Pour ce troisième et dernier cycle des IA, je vous propose ici un jeu : imaginer le SEO tel qu’il sera en 2022.

A l’instar d’Isaac Asimov, l’auteur de science-fiction qui m’a inspiré le titre de cette série d’articles, j’ai décidé de terminer le cycle des IA sur une démarche prospective et j’ai pour cela choisi de donner la parole à des visionnaires. Ils nous expliquent comment, sur la base d’observations et d’intuitions, ils se préparent aujourd’hui pour le SEO de demain.

Cet article est la dernière partie de ma série dédiée à l’intelligence artificielle :

- Le cycle des IA 1 : Exploiter la big data pour le SEO

- Le cycle des IA 2 : Stratégies SEO pour faire face à l’IA

- Le cycle des IA 3 : 2022, quel futur pour le SEO ? (VOUS ÊTES ICI)

Évolutions et avenir du SEO avec la montée de l’IA

Lorsque je débutais le SEO en 2012 et décidais d’acheter mon premier livre de SEO pour m’y mettre à fond, j’étais loin de me douter quel virage allait prendre mon métier 5 ans plus tard. On parle aujourd’hui sans rougir de big data et de data science, mais de quoi parlerons-nous dans 5 ans ?

Sylvain Peyronnet, Olivier Andrieu, Vincent Terrasi et Aysun Akarsu ont tous marqué d’une façon certaine ma façon de voir et de faire du search marketing, qu’ils m’aient mis le pied à l’étrier, ouvert les chakras ou donner envie de dépasser les limites du SEO tel que je le connaissais. J’ai donc particulièrement souhaité avoir leur point de vue pour terminer ce Cycle des IA en beauté par un tour de Delorean.

Avec l’IA qui prend de + en + de place dans les SERP et les outils SEO qui progressivement automatisent nos tâches et guident nos stratégies, à quoi ressemblera le métier SEO dans les années à venir ?

L’automated machine learning va permettre d’intégrer des techniques de plus en plus sophistiqué dans nos métiers

Si je résume la situation en 2017, le Machine Learning est de plus en plus utilisé dans les outils SEO (OnCrawl, Cocoon Se, SEOquantum, etc). Toutes les techniques de NLP sont maitrisées et proposées en quelques clics (Text Summarization, Ngram, Corpus, Word2Vec, …), sans compte les techniques avancées sur les time series (Détection d’anomalies) ou les logs (Process Mining)

En 2018, je suis certain que l’AML (Automated Machine Learning) va permettre de faire un bon prodigieux et d’intégrer des techniques de plus en plus sophistiqué dans les outils et les métiers de chacun (Xgboost, RandonForest, Lime). En parallèle, les logiciels de data visualisation sont devenus faciles à utiliser et moins onéreux car il existe beaucoup de solutions Open Source.

À l’heure actuelle, les logiciels SEO doivent penser à des connecteurs avec DataStudio, Power BI, Tableau Software ou Qlik View. Nous pouvons donc désormais utiliser des techniques sophistiqués et les rendre accessible au plus grand nombre. Le deep learning reste un peu moins utilisé par les logiciels SEO car il demande beaucoup de temps de calcul et donc il y a une problématique du coût. Par exemple, si nous prenons les résumés de texte, les techniques extractives fonctionnent bien (lexrank, textrank, fasttesx, lsa) mais les méthodes abstractives commencent à donner des résultats si on peut investir 30 000$ dans du GPU pour entrainer son modèle.

D’ici 2020, je pense que les coûts d’infrastructure vont considérablement se réduire. Les technologies suivantes deviendront très accessibles :

- Generative Learning : Génération d’images, de textes, de sons

- Reinforcement Learning : Capacité à prendre des décisions en fonction de son état courant avec un système de récompense (Exemple : Deepmind)

- Transfer Learning : Transférer des connaissances d’une ou plusieurs tâches sources vers une ou plusieurs tâches cibles.

Le SEO a considérablement changé d’un point de vue technique mais aussi d’un point de vue de la reconnaissance. Aujourd’hui Google porte beaucoup de considérations aux experts SEO en les accompagnant sur les nouveaux sujets (AMP, Rich Snippet) car cela aide à la diffusion des bonnes pratiques.

Par contre, on peut se demander si en 2022, les moteurs de recherche actuels, avec un champs pour saisir les mots clés, existeront toujours ! Il y a une arrivée très importante des assistants personnels avec l’explosion de la recherche vocale. D’après le cabinet de conseil et de recherche Ovum, en 2021, le nombre de terminaux intégrant des assistants numériques dépassera 7,5 milliards !

Il y a fort à parier que les ventes de clavier vont décroitre. De plus le protocole Ethereum (basé sur la blockchain) fait son entrée depuis 2015 avec l’apparition de réseaux décentralisés. Il est tout à fait possible qu’un moteur de recherche ouvert et open source fasse son apparition dans les 5 prochaines années. Presearch.io se lance dans cette direction et les facteurs de ranking seront connus et clairement communiqués, ce qui changera considérablement la donne.

La profession en 2022 va s’ultra-spécialiser avec des nouveaux métiers encore plus pointus dans la Technique, le Marketing et le Contenu et ces nouveaux métiers seront reconnus et certifiés par des cycles de formation.

Le SEO est actuellement en train de vivre sa première vraie mutation

Il y a en ce moment une véritable “hype” autour de l’intelligence artificielle. Pour le grand public, et aussi pour la plupart des praticiens du SEO, la notion reste assez mystérieuse.

Pour les moteurs, ce qui se cache derrière le terme I.A est ce que l’on appelle de l’apprentissage automatique (machine learning ou ML en anglais). Et du ML, on en trouve à tous les étages d’un moteur, voici quelques exemples :

- Pour la classification : à l’aide d’arbres de décisions (algorithmes random forest ou C5.0 par exemple), à l’aide de réseaux de neurones, à l’aide de SVM, il est possible de déterminer la thématique d’une page (sport, adulte, commerce, etc.), sa qualité (est-ce du spam ou non ?), sa langue, etc.

- Pour le scoring : pour donner un score à une page web en vue de créer une SERP, il faut pondérer chacun des signaux que le moteur utilise. Cette pondération n’est pas un absolu : il n’existe pas de règle fixe qui dit que le pagerank vaut 40% du score, que la sémantique vaut 30%, etc. En pratique, un algorithme de ML (de type learning2rank) va pondérer en temps réel les signaux par rapport à une satisfaction utilisateur estimée en monitorant le comportement des internautes sur le moteur.

- Pour traduire automatiquement d’une langue à une autre avec du deep learning (utilisation de LSTMs par exemple).

La démarche n’est pas magique : à chaque fois on va nourrir des algorithmes d’apprentissage de données généralement créées par des humains (des pages déjà classées par exemple) pour construire un processus de décision automatique qui va mimer la décision humaine. C’est d’ailleurs en cela que réside une partie des “dangers de l’IA” : si on automatise des mauvaises décisions, on les amplifie !

Ce que le moteur fait pour “comprendre” et mimer les décisions humaines, les SEOs peuvent le faire pour comprendre et mimer les décisions du moteur. C’est pour cela que le SEO est actuellement en train de vivre sa première vraie mutation. En effet, un moteur c’est un gigantesque entrepôt de données, avec une structuration spécifique. Le métier du SEO c’est de comprendre cette structure et ces données, c’est donc un métier de la data. (Note de Rémi : voir mon article Data Science SEO : une brève histoire de mon avenir)

Comprendre la data, cela peut se faire de plusieurs manières, mais la manière la plus productive est d’utiliser des outils d’analyse de données, dont la plupart sont basés sur des algorithmes de machine learning.

On peut envisager assez aisément que dans les 2 à 3 prochaines années la quasi totalité des audits de sites web se fera avec des outils d’analyse de données pour les bases techniques, et avec des outils de machine learning ou similaire pour les aspects plus évolués.

Il y a déjà quelques acteurs qui oeuvrent en ce sens : on peut actuellement faire le reverse engineering des filtres, on peut prédire les rankings, on peut analyser la sémantique avec des outils type 1.fr, visiblis, metamots et yourtext.guru, on peut déterminer la qualité des contenus, on peut savoir si les contenus sont en duplication, on peut croiser logs et informations de trafic (issues de GA par exemple). Bref, on peut déjà faire automatiquement une grande partie de l’analyse d’un site.

Ce que l’on ne sait pas encore totalement automatiser, c’est la partie amont (choix des mots-clés par exemple), et la partie aval (que faut-il actionner à la vue des résultats de l’audit ?). Il reste également difficile d’automatiser le choix des backlinks, mais on y arrivera prochainement.

Certaines des prérogatives actuelles des SEOs vont disparaître, ou en tout cas le travail sera fait différemment, avec une automatisation qui valorisera la supervision plus que la réalisation. Exemple typique : les opérations de désaveu de liens toxiques finiront par être totalement automatisées. La valeur ajoutée du SEO sera donc de décider de l’opération, mais pas de la faire.

Tout ceci signifie également que le niveau de technicité requis pour faire du SEO sera plus haut, il faudra savoir utiliser les outils, comprendre au moins le principe des algorithmes des moteurs et de machine learning. Être capable de faire de l’analyse de données avec R ou python (Note de Rémi : voir l’article Utiliser R pour le SEO), et des outils d’automatisation (avec python ou autre) seront des plus décisifs pour les profils SEO.

A côté, certaines tâches resteront encore assez longtemps l’apanage de l’humain : la partie recherche marketing en amont, le copywriting et la rédaction.

Une nouvelle ère du SEO s’ouvre, avec de nouvelles opportunités !

Ne pas savoir utiliser le machine learning demain sera l’équivalent de ne pas savoir utiliser un ordinateur aujourd’hui

Quand nous parlons du passé, du présent et du futur de la recherche, nous n’avons pas d’autres choix que de parler de Google. Mais connaissons-nous toujours aussi bien cette société, dont le moteur de recherche reste le plus utilisé à l’heure actuelle ? Sundar Pichai, le CEO actuel a récemment défini le but de Google (le 17/05/2017) : devenir une « AI First Company ».

Par le passé certains concurrents de Google étaient les réseaux sociaux mais ce n’est plus le cas aujourd’hui. Depuis 2015 les gens passent plus de temps dans les applications de messagerie (comme WeChat) que dans les médias sociaux. En réalisant cela, Google a racheté DeepMind en 2014 et a laissé tomber sa quête de conquérir les réseaux sociaux. Depuis il n’a pas seulement abandonné le marché des réseaux sociaux mais aussi le marché de la recherche. Dans une interview de 2016, Eric Schmidt annonçait d’ailleurs que Google était en train de migrer « de la recherche vers la suggestion” d’après les dires de Larry Page.

Aujourd’hui avec des produits comme Google Now, Google Assistant et Google Home, Google avance vers son ambition d’être une « AI First Company ». Aucun de ces produits ne sont des produits de Web ou nécessitant l’utilisation des navigateurs. Dans l’avenir nous pourrons constater que le transfert de la data va se faire du cloud vers l’utilisateur final, sans passer par les navigateurs.

En se passant des navigateurs et du web, Google ne va t-il pas non plus se passer de nous, éditeurs de sites, professionnels du SEO, etc ? Je ne pense pas. Google et les autres géants d’Internet comme Facebook et Amazon auront toujours besoin de data. Autrement dit, ils dépendent de la data que nous leur fournissons ou transmettons. Cela ne devrait pas changer dans l’avenir. Et il y aura toujours besoin des personnes qui peuvent être utiles dans ce transfert de data : les professionnels du SEO.

Dans ma conférence « Recherche et SEO, aujourd’hui et demain », j’avais expliqué ma vision des transformations à venir du métier de SEO : nous avançons vers un métier de personnalisation, aussi bien dans l’assistance, dans le transfert et la structuration de data. Certains consultants SEO se tournent vers des leviers comme l’UX ou la data en aidant par exemple les entreprises dans l’implémentation du balisage schema.org, AMP ou la migration vers le HTTPS et HTTP2. Je pense également qu’il y a aura de plus en plus de Search Data Scientists qui obtiennent des insights, font des algos, des tests avec la big data (Note de Rémi : voir l’article La big data dans le SEO)

J’ai utilisé et j’utilise encore la big data et la data science pour l’optimisation de moteurs de recherche. Le SEO a tous les éléments et les ressources de big data, les fameux 5V du big data : volume, velocity, variety, veracity, value. La data venant notamment du crawl des sites, des serveurs logs, des outils web analytiques, des APIs ou bien depuis les SERPS. Recueillir, manipuler et croiser toutes ces données nécessite des connaissance en big data et data science.

Comment je me prépare à l’avenir du search ? J’apprends le Machine Learning et le Deep Learning, et je m’améliore tous les jours sur la manipulation de big data. Je pense que si aujourd’hui quelqu’un qui ne sait pas comment utiliser les ordinateurs est ignorant, demain quelqu’un qui ne saura pas comment utiliser le machine learning sera dans le même cas.

(Note de Rémi : préparation d’un livre sur l’utilisation de la data science (machine learning, big data) pour le SEO en cours. Plus d’infos sur le livre SEO ici.)

Les applications du SEO vont être bouleversées par la recherche vocale

Depuis plus de 20 ans que le métier de SEO existe, celui-ci a toujours eu comme objectif de s’adapter au fonctionnement des moteurs de recherche et des usages des internautes et termes de search. Donc, pour tenter de comprendre l’évolution du référencement, il est important d’analyser celle de Google avant tout.

Or, quelques chiffres nous donnent de nombreuses pistes intéressantes à ce niveau :

– Aujourd’hui, plus de 50% des requêtes sur le moteur se font sur mobile dans le monde (via smartphone, Amazon Echo, Google home, etc.).

– Sur ces requêtes, plus de 20% sont vocalisées.

Je pourrais citer des dizaines d’autres statistiques et études. Elles suivent toutes la même voie : on assiste actuellement à un changement de paradigme dans la recherche d’informations sur le Web : on passe de la saisie de mots clés dans un formulaire à une question posée vocalement en langage naturel. Qu’on le veuille ou non, nos habitudes sont en train de changer et Google s’en rend compte, puisqu’il adapte depuis 2008 ses algorithmes à cette nouvelle donne, et notamment au travers d’Hummingbird (2013) et Rankbrain (2015).

Notre métier va donc devoir s’adapter et, même si les méthodologies vont rester les mêmes dans leurs grandes lignes, la façon de les appliquer va être bouleversée :

- La recherche de mots clés va devenir une recherche des questions que se posent les internautes pour trouver un site ou une information. Des outils comme Answer The Public (https://answerthepublic.com/) et 1.fr (https://1.fr/q) deviendront vite indispensables dans ce but. D’autres arriveront très bientôt, certainement.

- Google devenant de plus en plus en plus un moteur de réponse (voire de vérité), ce n’est plus la première page de résultats qu’il va falloir viser, mais la « position zéro » (ce qui s’affiche au-dessus des résultats naturels) et notamment le « featured snippet » (extrait d’une page web affiché par Google lorsqu’on pose une question en ligne).

- Il faudra ensuite, pour chaque question identifiée, répondre au travers d’une page web unique (une question traitée pour chaque page), de façon optimisée, tout en étant pertinent et exhaustif sur le sujet, afin d’apparaître dans cette zone.

Les requêtes de courte traîne pourront peut-être encore se traîter « à l’ancienne » pendant quelques temps, on verra. Mais la longue traîne aujourd’hui et la moyenne traîne demain matin seront traitées vocalement. Et il faut s’y préparer dès maintenant, tout étant conscient des risques que tout cela comporte pour chacun d’entre nous et les générations futures : le fait que Google renvoie un seul résultat à une demande vocale génère un affaiblissement du réflexe de recoupement de l’information, de validation de la source et, plus globalement un appauvrissement intellectuel qui doit nous faire réfléchir aux conséquences humaines d’une telle évolution…

Au sujet de Rankbrain, je pense qu’il a a été conçu pour « comprendre » les requêtes et préparer / adapter les algorithmes Google à la recherche vocale. Quand on parle « vocal search », on parle de Rankbrain et inversement… Il s’agit d’une brique de plus dans les algos Google. Ce n’est pas Rankbrain qui va changer le SEO, c’est la recherche vocale… Rankbrain, c’est de la « plomberie interne » au moteur, peu importe pour nous… Enfin, c’est ma vision 🙂

Le début d’une nouvelle histoire

L’impact des IA sur le marketing digital ne fait que commencer : le machine learning, le deep learning et le big data sont des sujets de plus en plus chauds dans le domaine du SEO. C’est le début d’une nouvelle histoire, pas la fin.

Je tiens à remercier tous les intervenants qui ont fait de cette série d’articles un succès : Gregory Florin, Julien Deneuville, Aurélien Berrut, Kévin Richard, Raphaël Doucet, David Carles, Christian Méline, Anthony Técher, Yann Sauvageon, Aysun Akarsu, Vincent Terrasi, Sylvain Peyronnet et Olivier Andrieu.

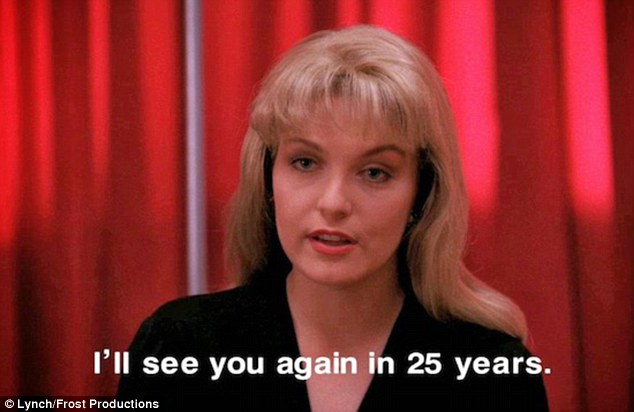

À la manière d’un Twin Peaks de la grande époque, je vais laisser reposer ce dernier épisode pendant 25 ans quelques années ! Laissez un commentaire si le Cycle des IA vous a plu et surtout partagez, partagez, PARTAGEZ !!!

Pour ceux qui suivent le projet, la préparation du livre « La Data Science pour le SEO » que j’écris avec Vincent Terrasi a franchi un cap. Nous avons été contactés par un éditeur et discutons en ce moment des conditions de sortie du livre. N’hésitez pas à vous inscrire ici pour être informé de la sortie :

Pour les plus téméraires, rejoignez-moi sur sur Twitter pour DU FUN EN BARRE :

«I will see you again in 5 years. Meanwhile…»

Bonjour Rémi,

Tout d’abord, un grand merci pour cette série d’articles qui s’affranchit avec brio des sujets « classiques » que l’on voit circuler habituellement.

L’article le plus intéressant est le troisième avec cette interrogation : que sera véritablement le SEO dans 5, 10 ou 20 ans ? On aura le temps d’en faire la rétrospective mais d’ici là, j’ai hâte de lire d’autres articles sur l’utilisation de R notamment 🙂 !

Alice

Bonjour Alice,

Peut-être que la « Data Science SEO » deviendra aussi un sujet « classique » 😉

Le prochain article sera sûrement autour de R.

Il faut l’espérer, je pense que l’avenir de notre métier se trouve là 🙂 et ça n’en deviendra que plus passionnant encore.